A corrida por modelos de inteligência artificial cada vez mais poderosos e confiáveis ganhou um novo protagonista: o Scale Evaluation, uma ferramenta desenvolvida pela Scale AI para testar e diagnosticar o desempenho de IAs avançadas em múltiplos cenários.

Mais do que uma simples plataforma de benchmark, a Scale Evaluation representa um salto qualitativo na forma como avaliamos, entendemos e aprimoramos algoritmos de IA. Mas o que exatamente essa ferramenta oferece — e por que ela está sendo adotada por líderes do setor?

O Que É a Ferramenta Scale Evaluation?

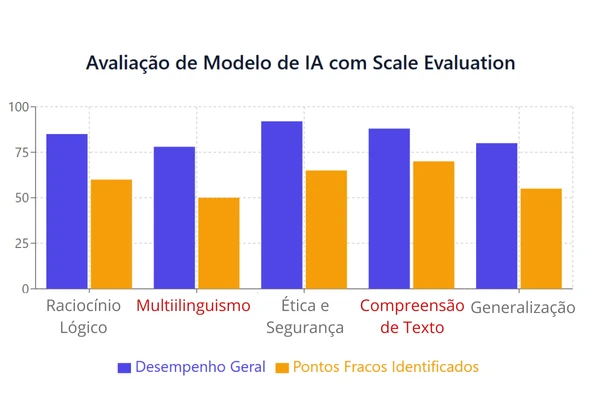

O Scale Evaluation é um sistema automatizado que testa modelos de IA em uma variedade de benchmarks e tarefas específicas, como raciocínio lógico, compreensão de linguagem, geração de texto e comportamento ético.

A ferramenta analisa:

- Precisão e coerência de respostas;

- Rendimento em diferentes idiomas;

- Respostas frente a perguntas adversariais ou tendenciosas;

- Aderência a comportamentos éticos e instruções de segurança.

Além disso, fornece relatórios detalhados com insights sobre falhas e recomendações sobre quais dados devem ser reforçados no treinamento.

De Força de Trabalho Humana à Automação Inteligente

A Scale AI ganhou notoriedade por oferecer força de trabalho humana qualificada para anotar dados e testar modelos de IA. Agora, com o Scale Evaluation, ela automatiza esse processo usando algoritmos próprios de aprendizado de máquina.

Essa transição é um reflexo da própria evolução da IA: tarefas que antes exigiam revisão manual agora são realizadas por sistemas inteligentes com eficiência e profundidade analítica superior.

Aplicações na Inteligência Artificial

O Scale Evaluation não é apenas uma ferramenta de análise — ele atua como um espelho preciso da performance dos modelos de IA em situações reais e críticas. As principais aplicações incluem:

- Refinamento de modelos de linguagem (LLMs);

- Testes de robustez e generalização;

- Identificação de viés e comportamento inadequado;

- Avaliação de desempenho multilíngue;

- Criação de ciclos de melhoria contínua com feedback baseado em dados.

Empresas que desenvolvem grandes modelos estão usando o Scale Evaluation para detectar desempenho insatisfatório em idiomas não-ingleses ou limitações no raciocínio de múltiplas etapas — falhas que poderiam passar despercebidas sem testes especializados.

Benchmarks Exclusivos: EnigmaEval e MASK

Como parte de sua iniciativa, a Scale AI também desenvolveu novos benchmarks:

- EnigmaEval: Foca no raciocínio complexo, lógica e resolução de problemas;

- MASK: Avalia segurança, moralidade e aderência a instruções éticas.

Esses benchmarks complementam o Scale Evaluation e ajudam a estabelecer metodologias de avaliação mais rigorosas, essenciais para garantir que modelos avançados se comportem de forma previsível e confiável.

Reconhecimento Oficial e Adoção Governamental

A relevância da ferramenta é tamanha que ela já foi adotada pelo Instituto Nacional de Padrões e Tecnologia dos EUA (NIST). Isso aponta para uma tendência de padronização oficial na avaliação de IA, o que pode influenciar regulações, certificações e práticas de mercado no mundo todo.

Desafios e Implicações Éticas

Embora o Scale Evaluation represente um avanço notável, seu uso também levanta questões importantes:

- Até que ponto confiamos na automação para julgar o comportamento de outras IAs?

- A padronização pode inibir a diversidade de abordagens criativas?

- Como garantir que os benchmarks não reflitam vieses implícitos da própria ferramenta?

Esses desafios reforçam a necessidade de transparência, auditabilidade e supervisão humana contínua, mesmo em um processo cada vez mais automatizado.

O Futuro da Avaliação de Modelos de IA

Com a popularização de modelos como GPT, Claude e Gemini, a exigência por ferramentas confiáveis de diagnóstico e aprimoramento tornou-se essencial. O Scale Evaluation é um passo decisivo nessa direção, sinalizando uma era de:

- IA mais responsável e segura;

- Melhor entendimento das capacidades e limitações dos modelos;

- Ciclos de treinamento mais eficientes e personalizados.

Espera-se que, com o tempo, a ferramenta seja integrada diretamente aos ambientes de desenvolvimento de IA, tornando-se parte fundamental do pipeline de produção de modelos.

Conclusão: Avaliar Para Evoluir

A Scale AI, com sua ferramenta Scale Evaluation, não apenas automatizou o diagnóstico de modelos de IA, como também elevou o padrão de excelência exigido na construção dessas tecnologias. Em um mundo onde a inteligência artificial assume papéis cada vez mais centrais, saber onde ela erra — e por quê — é tão importante quanto aprimorar seu acerto.

E você, desenvolvedor, pesquisador ou entusiasta: já pensou em como está avaliando as inteligências que constrói?